Quels sont les avantages des NAS avec stockage en RAID pour la redondance des données ?

Le NAS : un système de stockage réseau performant Comme vous le savez peut-être déjà, le NAS,[…]

Comment choisir un moniteur portable pour une productivité en déplacement ?

Avec l’évolution constante de la technologie et de l’ère numérique, nous sommes de plus en plus amenés[…]

Comment augmenter la durée de vie de la batterie d’un smartphone Android ?

Qui ne s’est jamais retrouvé avec un smartphone aux bras morts, au milieu de nulle part, sans[…]

Comprendre l’importance du refroidissement liquide pour votre PC

Dans le monde des jeux sur ordinateur, la performance est primordiale. Il ne s’agit pas uniquement de[…]

Les défis de la maintenance et du nettoyage des composants PC

Dans un monde où l’informatique règne en maître, l’optimisation et la maintenance des ordinateurs sont devenues de[…]

Comment les standards de transmission de données évoluent-ils dans le hardware actuel ?

Dans notre monde hyper-connecté, la transmission de données est au cœur de notre vie quotidienne. Des smartphones[…]

Peut-on construire un PC entièrement avec des composants open-source ?

En parcourant la toile, vous êtes tombé sur une idée un peu folle : est-il possible de[…]

Quelle est l’importance de la gestion de l’énergie pour les dispositifs informatiques modernes ?

Dans un monde où la consommation d’énergie est devenue une préoccupation centrale, tant pour les questions environnementales[…]

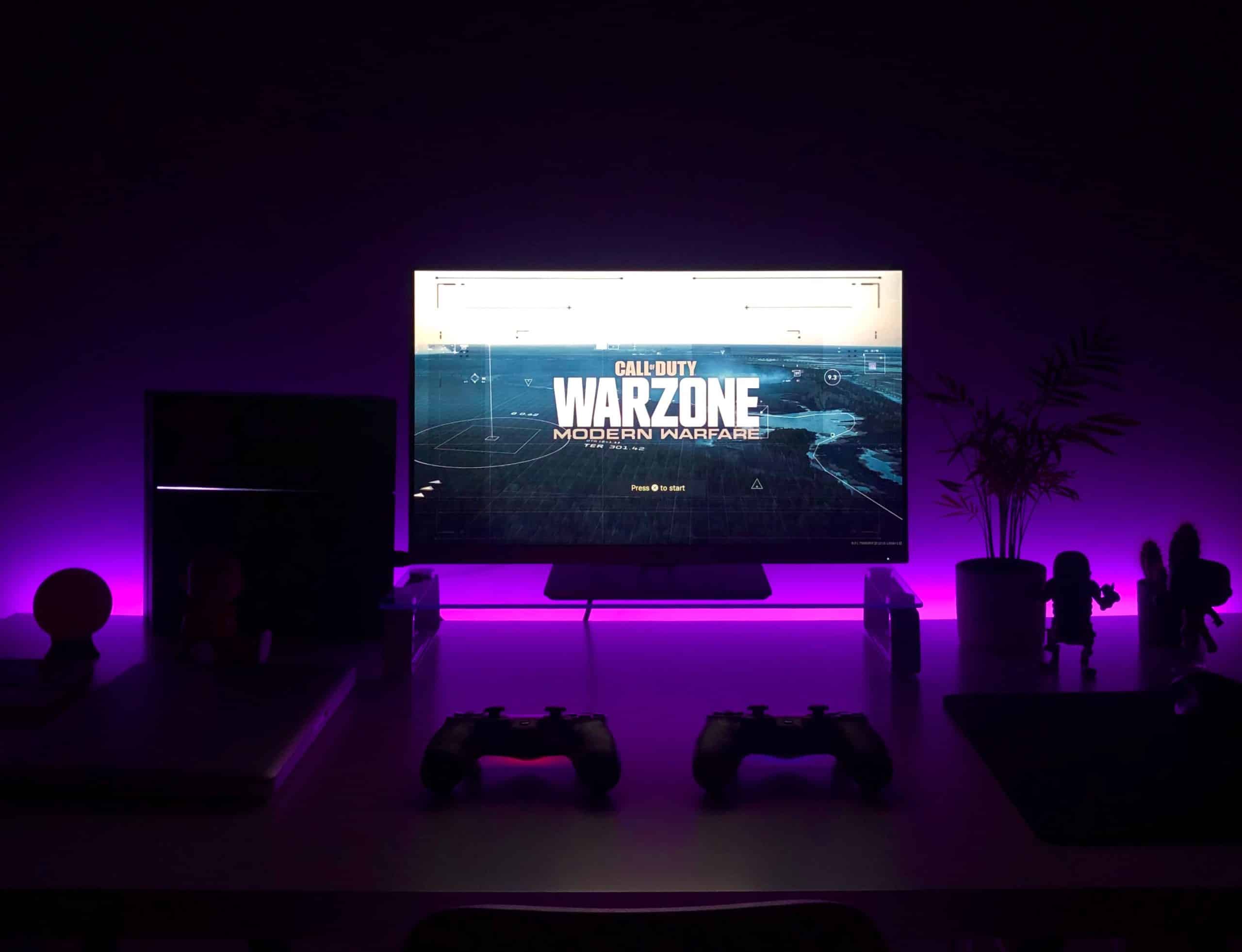

Comment les systèmes de refroidissement avancés améliorent-ils les performances des PC gaming ?

En tant que grands passionnés de jeux vidéo, vous savez probablement que les performances de votre ordinateur[…]